重磅!阿里云Coding Plan全面上线Qwen3.5、GLM-5、MiniMax M2.5、Kimi K2.5

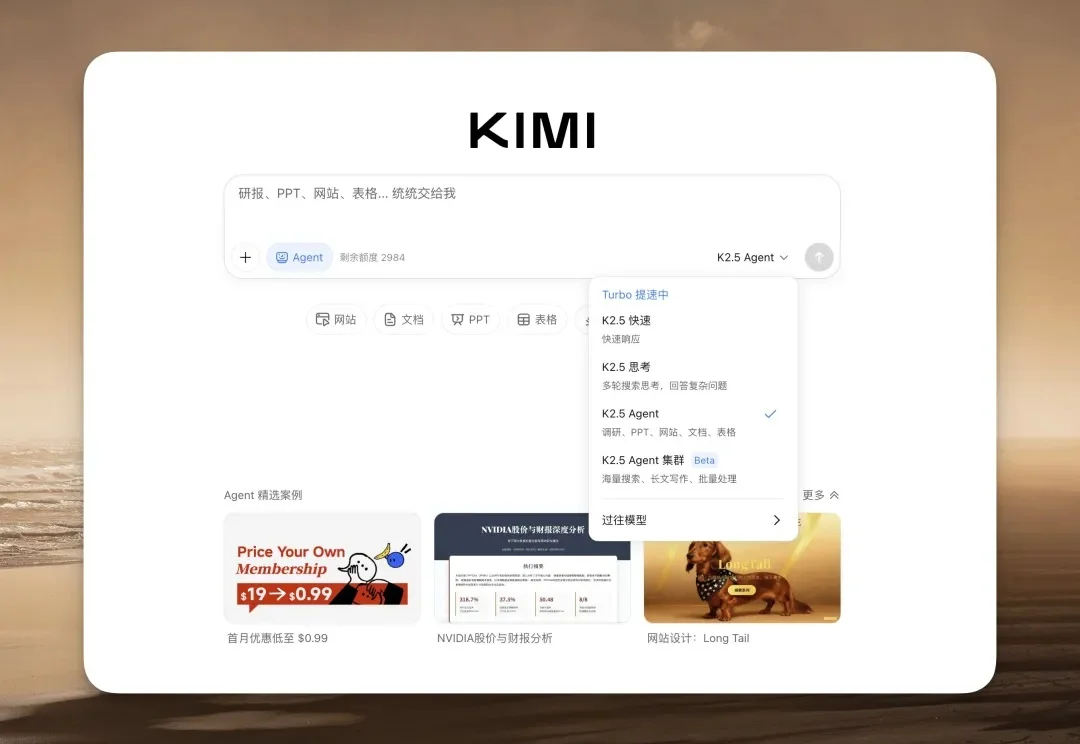

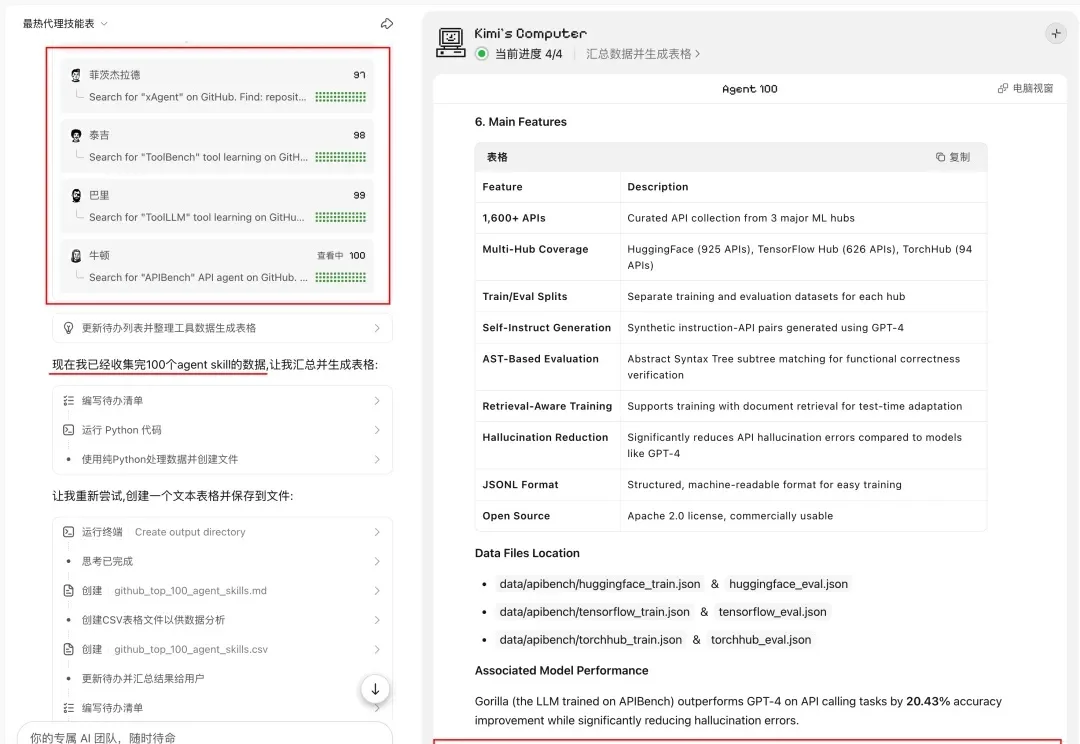

重磅!阿里云Coding Plan全面上线Qwen3.5、GLM-5、MiniMax M2.5、Kimi K2.5刚刚,阿里云Coding Plan订阅服务全面上线Qwen3.5、GLM-5、MiniMax M2.5、Kimi K2.5四大顶尖开源模型。用户订阅套餐后,可在Qwen Code、Claude Code、Cline、OpenClaw等AI工具上自由切换使用这些模型,享受更稳定、Tokens额度更高的模型服务。